Техносемантика жеста: о возможностях использования пермской жестовой нотации в программно-генерируемых средах

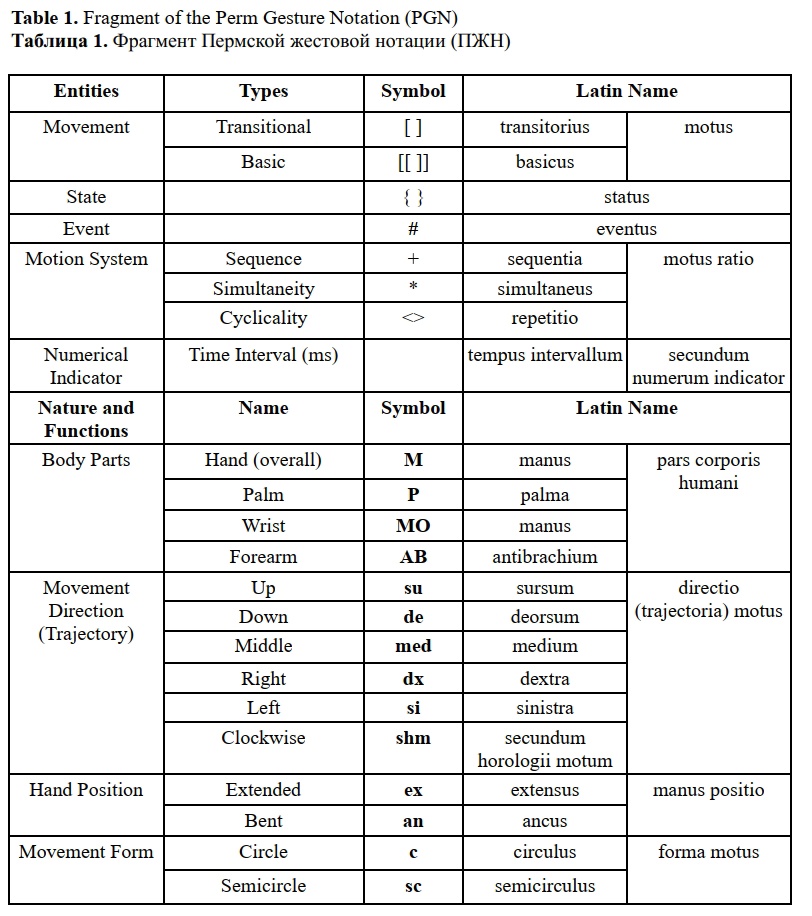

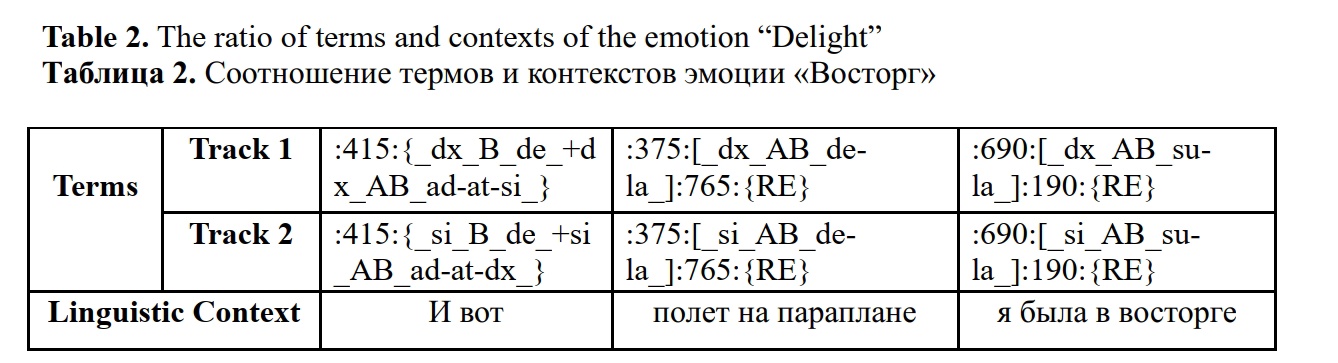

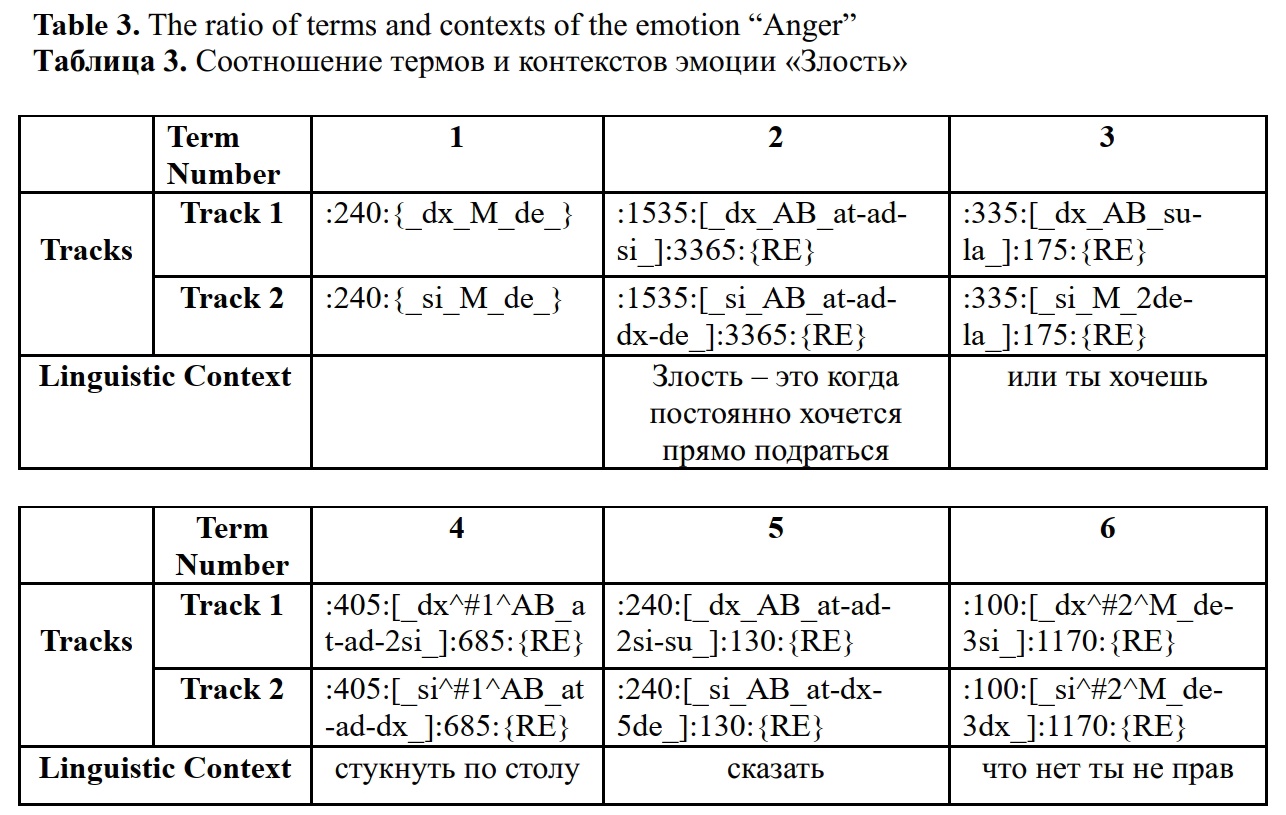

Статья посвящена разработке концепции и программного решения генерации движений человека на основе созданной коллективом семантико-ориентированной жестовой нотации. Нотация представляется в виде формулы, отличающейся гибкой структурой понятий и правил их реализации, что позволяет легко адаптировать изменения параметров движения для соответствия идеальному или реальному образцу.

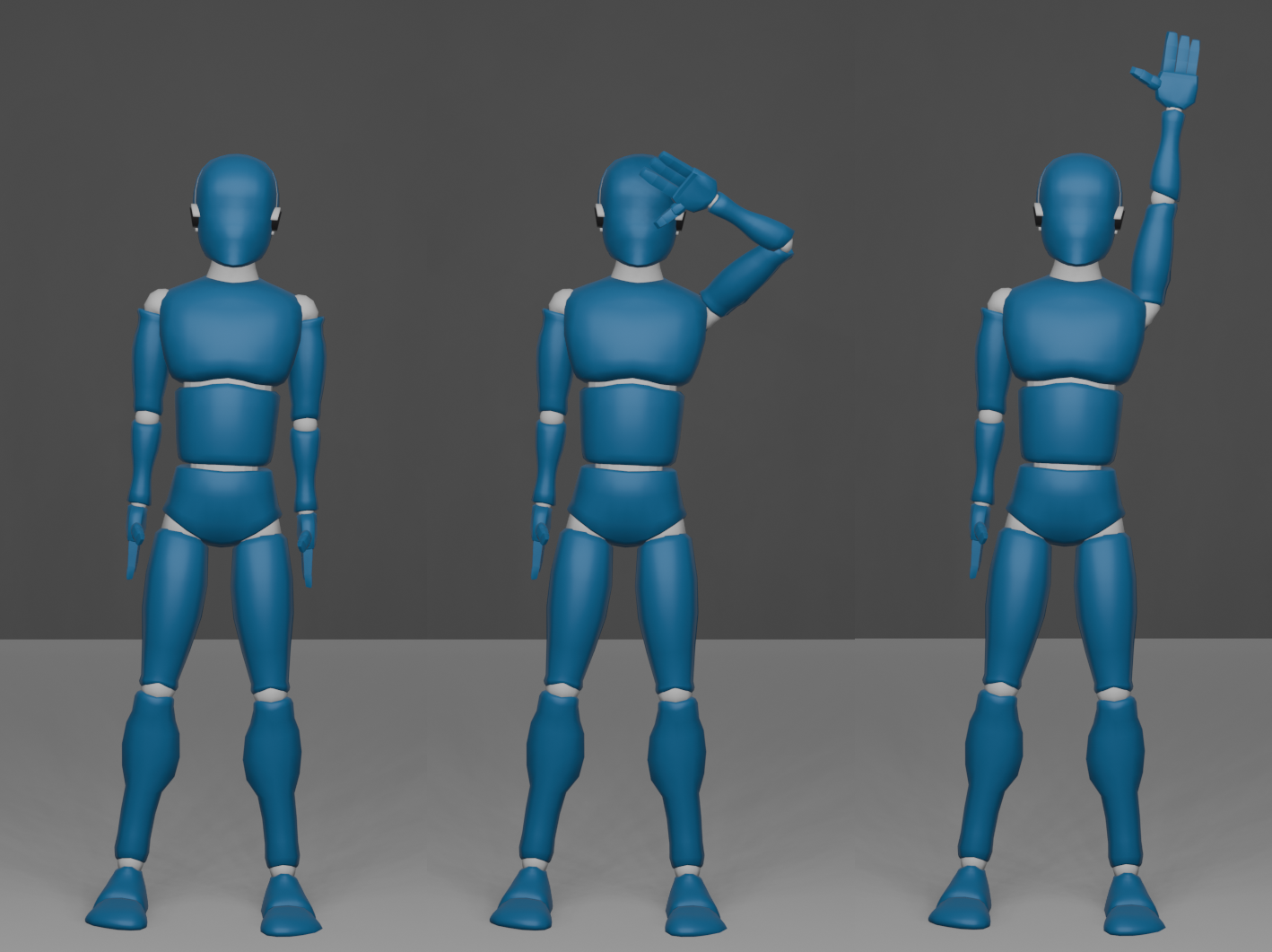

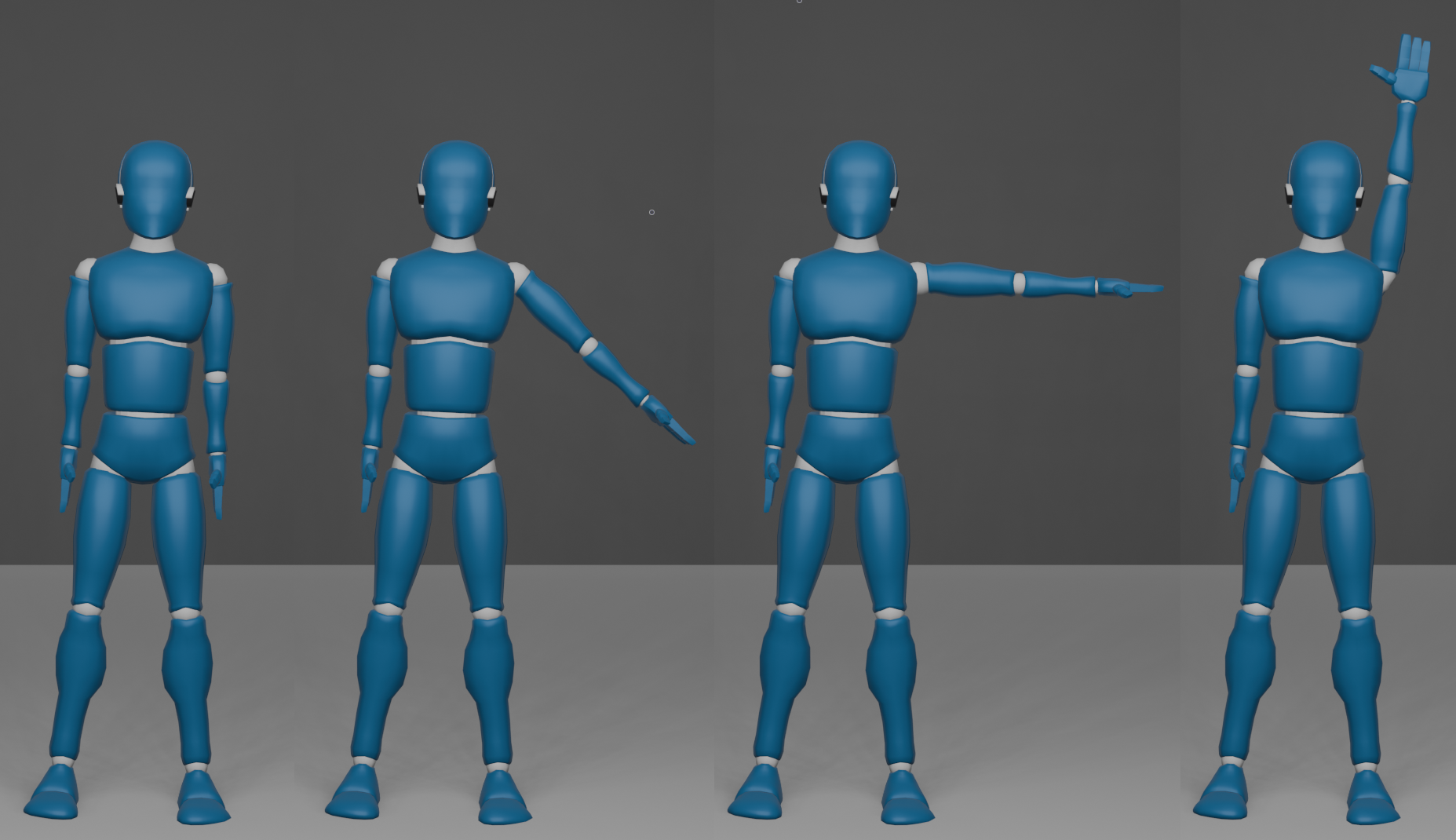

Для моделирования движений, представленных в языковой нотации, разработано кроссплатформенное приложение на базе игрового движка Blender 4.2 для визуализации и генерации анимации жестов антропоморфных моделей. Система управления движений состоит из следующих стадий: запись жестовой нотации; разбор этой записи; построение внутреннего представления движения, которое является последовательностью ряда кадров. Кадры имеют информацию о том, к какой кости (части тела) исполнителя они относятся, как влияют на её положение, в какой момент времени от начала движения этот кадр актуален. На последнем этапе осуществляется преобразование внутреннего представления движения в движение исполнителя, в качестве которого могут выступать как виртуальные антропоморфные 3D-модели, так и материальные программно-аппаратные комплексы в виде антропоморфных роботов.

Для большего соответствия антропоморфному поведению помимо «идеальных образцов» движения человека были использованы модели жестового поведения людей, представленные в специально создаваемом для этой цели коллективом мультимодальном корпусе. Материал представляет собой аудиовизуальные записи устных спонтанных текстов описания реципиентами широкого спектра собственных эмоциональных состояний. Полученные в ходе экспериментального исследования данные подтвердили гибкость, повышенную контролируемость и модульность языковой нотации, возможность моделирования непрерывного пространства человеческой двигательной активности.

Иллюстрации

Белоусов К. И., Талески А., Агаев А. Р. Техносемантика жеста: о возможностях использования пермской жестовой нотации в программно-генерируемых средах // Научный результат. Вопросы теоретической и прикладной лингвистики. 2024. Т. 10. № 4. C. 126–146.

Пока никто не оставил комментариев к этой публикации.

Вы можете быть первым.

Abbie M. Movement notation // The Australian journal of physiotherapy. 1974. Vol. 20 (2). Pp. 61–69. https://doi.org/10.1016/S0004-9514(14)61177-6

Bashan M., Einbinder H., Harries J., Shosani M., Shoval D. Movement Notation: Eshkol and Abraham Wachmann. Köln: Verlag der Buchhandlung Walther König, 2024.

Belousov K. I., Sazina D. A., Ryabinin K. V., Brokhin, L. Yu. Sensory Technolinguistics: On Mechanisms of Transmitting Multimodal Messages in Perceptual-Cognitive Interfaces // Automatic Documentation and Mathematical Linguistics. 2024. Vol. 58, Issue 2. Pp. 108–116. https://doi.org/10.3103/s0005105524700079

Benesh R., Benesh J. An Introduction to Benesh Dance Notation. London: A & C Black, 1956.

Bernardet U., Fdili Alaoui S., Studd K., Bradley K., Pasquier P., Schiphorst, T. Assessing the reliability of the Laban Movement Analysis system // PLoS ONE. 2019. Vol. 14 (6): e0218179. https://doi.org/10.1371/journal.pone.0218179

Birdwhistell R. L. Introduction to Kinesics: An Annotation System for Analysis of Body Motion and Gesture. Washington, DC.: Foreign Service Institute, 1952.

Bull P., Doody J. P. 8 Gesture and body movement. De Gruyter eBooks, 2013. Pp. 205–228. https://doi.org/10.1515/9783110238150.205

Calvert T. Approaches to the Representation of Human Movement: Notation, Animation and Motion Capture // Dance Notations and Robot Motion, Springer Tracts in Advanced Robotics. 2015. Pp. 49–68. https://doi.org/10.1007/978-3-319-25739-6_3

Dael N., Mortillaro M., Scherer K. R. The Body Action and Posture Coding System (BAP): Development and Reliability // Journal of Nonverbal Behavior. 2012. Vol. 36 (2). Pp. 97–121. https://doi.org/10.1007/s10919-012-0130-0

Dell C. A Primer for Movement Description: Using Effort-shape and Supplementary Concepts. New York: Dance Notation Bureau Press, 1977.

Duprey S., Naaim A., Moissenet F., Begon M., Chèze, L. Kinematic models of the upper limb joints for multibody kinematics optimisation: An overview // Journal of Biomechanics. 2017. Vol. 62. Pp. 87–94. DOI: 10.1016/j.jbiomech.2016.12.005

Ekman P., Friesen W. V. Facial Action Coding System. Palo Alto, CA: Consulting Psychologists, 1978.

El Raheb K., Ioannidis Y. From dance notation to conceptual models: a multilayer approach // Proceedings of the 2014 International Workshop on Movement and Computing, MOCO, ACM. New York, 2014. Pp. 25–30.

El Raheb K., Buccoli M., Zanoni M., Katifori A., Kasomoulis A., Sarti A., Ioannidis Y. Towards a general framework for the annotation of dance motion sequences // Multimed Tools Appl. 2023. Vol. 82. Issue 3. Pp. 3363–3395. https://doi.org/10.1007/s11042-022-12602-y

Eshkol N., Wachmann A. Movement Notation. London: Weidenfeld and Nicolson, 1958.

Farnell B. M. Movement Notation Systems // The World’s Writing Systems / ed. Peter T. Daniels. Oxford University Press, 1996. Pp. 855–879.

Frishberg N. Writing systems and problems for sign language notation // Journal for the Anthropological Study of Human Movement. 1983. Vol. 2 (4). Pp. 169–195.

Frey S., Hirsbrunner H-P., Jorns U. Time-Series Notation: A Coding Principle for the Unified Assessment of Speech and Movement in Communication Research. Tübingen: Gunter NarrVerlag, 1982.

Grushkin D. A. Writing Signed Languages: What For? What Form? // American Annals of the Deaf. 2017. Vol. 161 (5). Pp. 509–527. https://doi.org/10.1353/aad.2017.0001

Guest A. H. Dance Notation: The Process of Recording Movement on Paper. New York: Dance Horizons, 1984.

Guest A. H. Labanotation: The System of Analyzing and Recording Movement (4th ed.). New York: Routledge, 2005. https://doi.org/10.4324/9780203823866

Harrigan J. A. Proxemics, Kinesics, and Gaze // The New Handbook of Methods in Nonverbal Behavior Research. 2008. Pp. 136–198. https://doi.org/10.1093/acprof:oso/9780198529620.003.0004

Izquierdo C., Anguera M. T. Movement notation revisited: syntax of the common morphokinetic alphabet (CMA) system // Front. Psychol. 2018. Vol. 9:1416. https://doi.org/10.3389/fpsyg.2018.01416

Karg M., Samadani A.-A., Gorbet R., Kuhnlenz K., Hoey J., Kulic D. Body Movements for Affective Expression: A Survey of Automatic Recognition and Generation // IEEE Transactions on Affective Computing. 2013. Vol. 4. Issue 4. Pp. 341–359. https://doi.org/10.1109/t-affc.2013.29

Kendon A. Gesture // Annual Review of Anthropology. 1997. Vol. 26 (1). Pp. 109–128. https://doi.org/10.1146/annurev.anthro.26.1.109

Key M. R. Nonverbal communication: a research guide and bibliography. Metuchen, N.J.: The Scarecrow Press, 1977.

Kilpatrick C. E. Movement, Gesture, and Singing: A Review of Literature // Update: Applications of Research in Music Education. 2020. Vol. 38. Issue 3. Pp. 29–37. DOI: 10.1177/8755123320908612

Laban R. von, Lawrence F. C. Effort: Economy of Human Movement / 2nd ed. London: Macdonald & Evans, 1974.

Laumond J., Abe N. Dance Notations and Robot Motion. Cham (ZG): Springer International Publishing AG, 2016. https://doi.org/10.1007/978-3-319-25739-6

Liu H., Zhu Z., Iwamoto N., Peng Y., Li Zh., Zhou Y., Bozkurt E., Zheng, B. BEAT: A Large-Scale Semantic and Emotional Multi-modal Dataset for Conversational Gestures Synthesis // Computer Vision – ECCV 2022. 2022. Pp. 612–630. https://doi.org/10.48550/arXiv.2203.05297

Murillo E., Montero I., Casla M. On the multimodal path to language: The relationship between rhythmic movements and deictic gestures at the end of the first year // Frontiers in Psychology. 2021. Vol. 12. Pp. 1–8. https://doi.org/10.3389/fpsyg.2021.616812

Novack A. M., Wakefield E. M. Goldin-Meadow S. What makes a movement a gesture? // Cognition. 2016. Vol. 146. Pp. 339–348. https://doi.org/10.1016/j.cognition.2015.10.014

Qi X., Liu C., Li L., Hou J., Xin H., Yu, X. Emotion Gesture: Audio-Driven Diverse Emotional Co-Speech 3D Gesture Generation, IEEE Transactions on Multimedia. 2024. Pp. 1–11. https://doi.org/10.1109/TMM.2024.3407692

Streeck J. The Significance of Gesture: How it is Established // Papers in Pragmatics. 2010. Vol. 2. Issue 1-2. https://doi.org/2.10.1075/iprapip.2.1-2.03str

Shafir T., Tsachor R., Welch K. B. Emotion Regulation through Movement: Unique Sets of Movement Characteristics are Associated with and Enhance Basic Emotions // Frontiers in Psychology. 2016. Vol. 6. https://doi.org/10.3389/fpsyg.2015.02030

Stults-Kolehmainen M. A. Humans have a basic physical and psychological need to move the body: Physical activity as a primary drive // Frontiers in Psychology. 2023. Vol. 14. https://doi.org/10.3389/fpsyg.2023.1134049

Tonoli R. L., Costa P. D. P., Marques L. B. d. M. M., Ueda L. H. Gesture Area Coverage to Assess Gesture Expressiveness and Human-Likeness’ // International Conference on Multimodal Interaction (ICMI Companion ‘24), 4–8 November 2024, San Jose, Costa Rica. ACM, New York, NY, USA. https://doi.org/10.1145/3686215.3688822

Trujillo J. P., Vaitonyte J., Simanova I., Özyürek A. Toward the markerless and automatic analysis of kinematic features: A toolkit for gesture and movement research // Behavior Research Methods. 2018. Vol. 51 (2). Pp. 769–777. https://doi.org/10.3758/s13428-018-1086-8

Van Elk M., van Schie H. T., Bekkering H. Short-term action intentions overrule long-term semantic knowledge // Cognition. 2009. Vol. 111. Issue 1. Pp. 72–83. https://doi.org/10.1016/j.cognition.2008.12.002

Yang S., Wu Z., Li M., Zhang Z., Hao L., Bao W., Zhuang H. QPGesture: Quantization-Based and Phase-Guided Motion Matching for Natural Speech-Driven Gesture Generation // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). 2023. Pp. 2321–2330. https://doi.org/10.48550/arXiv.2305.11094

Yoon Y., Cha B., Lee J.-H., Jang M., Lee J., Kim J., Lee G. Speech Gesture Generation from the Trimodal Context of Text, Audio, and Speaker Identity // ACM Transactions on Graphics. 2020. Vol. 39. Issue 6. https://doi.org/10.1145/3414685.3417838

Zhi Y., Cun X., Chen X., Shen X., Guo W., Huang S., Gao S. LivelySpeaker: Towards Semantic-Aware Co-Speech Gesture Generation // Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV). 2023. Pp. 20807–20817. https://doi.org/10.1109/ICCV51070.2023.01902